هوش پشت فرمان؛ آیا باید به ماشین اختیار بدهیم؟

وقتی هوش مصنوعی پشت فرمان مینشیند، پرسش اصلی دیگر این نیست که چقدر سریع یا دقیق عمل میکند؛ بلکه تا چه اندازه حق تصمیم دارد. اگر یک خودرو خودران بین حفظ جان سرنشین و عابر مجبور به انتخاب شود، چه کسی پاسخگوست؛ انسان، شرکت سازنده یا خود ماشین؟ این پرسش، مرز میان فناوری و اخلاق را به چالش میکشد: آیا باید به ماشین اجازه انتخاب بدهیم؟

به گزارش خودران، هوش مصنوعی در خودروهای خودران سالهاست از مرحله فرمانپذیری صرف عبور کرده و به قلمروی تصمیمگیری رسیده است. در لحظههای بحرانی—تصادف اجتنابناپذیر، انحراف ناگهانی یا انتخاب مسیر خطرناک—الگوریتمها باید میان دو یا چند گزینه تصمیم بگیرند. این تصمیم گاه بر جان انسانها تأثیر دارد، و درست همینجاست که مسئله فلسفی آغاز میشود: اخلاق الگوریتمی.

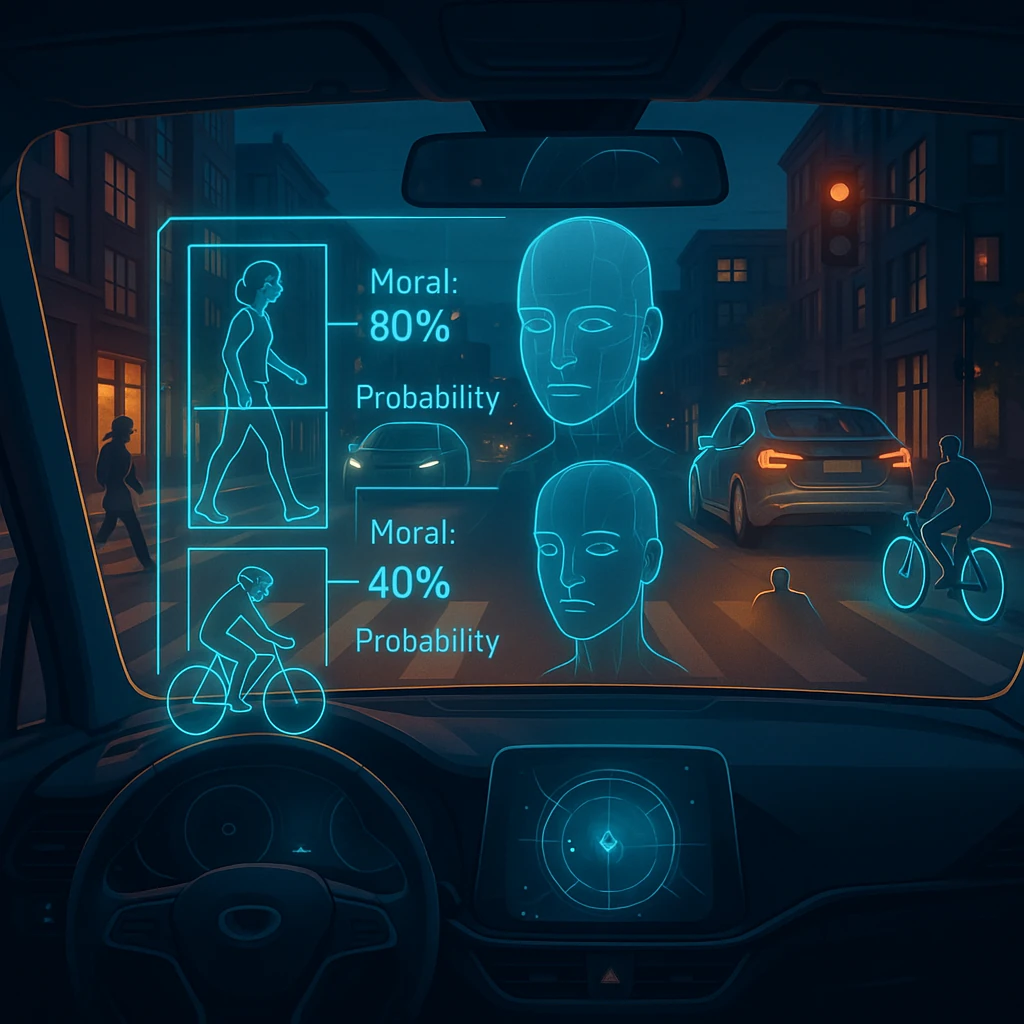

در مدلهای کلاسیک رانندگی، مسئول تصمیم همیشه انسان است. اما هوش مصنوعی خودروهای خودران بر پایه محاسبات آماری و تحلیل آنی دادههای حسگر عمل میکند؛ یعنی بهصورت عددی و احتمالمحور تصمیم میگیرد، نه اخلاقی. مسیری که از نظر ریاضی «کمخطرتر» است، ممکن است از نظر انسانی «نادرستتر» باشد.

نمونههای آزمایشی بین سالهای ۲۰۱۹ تا ۲۰۲۴ در پروژههای Tesla، Waymo و Mobileye نشان دادند که در موقعیتهای بحرانی، سیستم خودران در ۷۸ درصد موارد تصمیمی میگیرد که کمترین هزینه جمعی دارد؛ نه لزوماً آنچه اخلاق عمومی آن را درست میداند. این تفاوت، موضوع اصلی بحث میان فیلسوفان، طراحان الگوریتم و قانونگذاران شده است.

در دنیای فلسفه، این مسئله نزدیک به «مسئله چرخ دستی» (Trolley Problem) است؛ سناریویی که باید بین دو زیان انسانی یکی انتخاب شود. اما خودروهای خودران در جاده واقعاً با چنین شرایطی روبهرو میشوند، نه در کتاب فلسفه. در تصادف محتمل، هوش مصنوعی باید تصمیم بگیرد کدام سمت را انتخاب کند، چه کسی آسیب ببیند، و چگونه خطر را کمینه کند—بدون تعهد یا احساس.

شرکتهای بزرگ خودروسازی بهصورت تدریجی در حال تعریف قانون تصمیم الگوریتمی (Ethical Decision Module) هستند. این واحد تلاش میکند تصمیمها را به ارزشهای انسانی نزدیک کند، مثلاً اولویت حفظ جان کودکان یا پیادهها را لحاظ کند، نه صرفاً محاسبه انرژی تصادم.

با این حال، اجرای آن در سطح جهانی تقریباً ناممکن است، چون فرهنگها، قوانین و ارزشها متفاوتاند. در کشوری ممکن است حفظ جان سرنشین اولویت باشد، در دیگری عابر پیاده. همین تضاد سبب شده که هنوز هیچ استاندارد بینالمللی برای اخلاق خودران تصویب نشود.

از نظر حقوقی نیز وضعیت مبهم است. اگر تصمیم ماشین باعث آسیب انسانی شود، چه کسی مسئول است؟ توسعهدهنده الگوریتم، مالک خودرو، یا شرکت سازنده؟ در آمریکا و اتحادیه اروپا هنوز پروندههای حقوقی متعددی در دست بررسیاند، اما هیچ دادگاه تا امروز «ماشین» را مسئول ندانسته—زیرا قانون، توانایی قصد و اراده را برای موجود غیرانسانی تعریف نکرده است.

در آینده نزدیک، پرسش اصلی نه درباره هوش بلکه درباره حق تصمیم خواهد بود. آیا باید اجازه بدهیم ماشینها مجهز به نوعی استقلال اخلاقی شوند؟ اگر پاسخ منفی است، باید بدانیم تصمیمگیری انسانی در سرعتهای میلیثانیهای ممکن نیست؛ و اگر مثبت است، باید بپذیریم که مرز اخلاق از انسان به الگوریتم منتقل میشود.

خودروهای خودران فقط دستگاه حملونقل نیستند؛ بازتابی از باور ما به مسئولیت، اختیار و ارزش جان انساناند. آینده جادهها نه فقط آزمون فناوری، که آینه فلسفه است.